Mit generativer KI werden allgemein Anwendungen bezeichnet, die ausgehend von einer in der Regel natürlichsprachlichen Anweisung, dem sogenannten Prompt, neue digitale Inhalte erzeugen. Das können Texte sein, aber auch Bilder, Audios (Stimmen), Musik, Videos oder auch Programmcode.

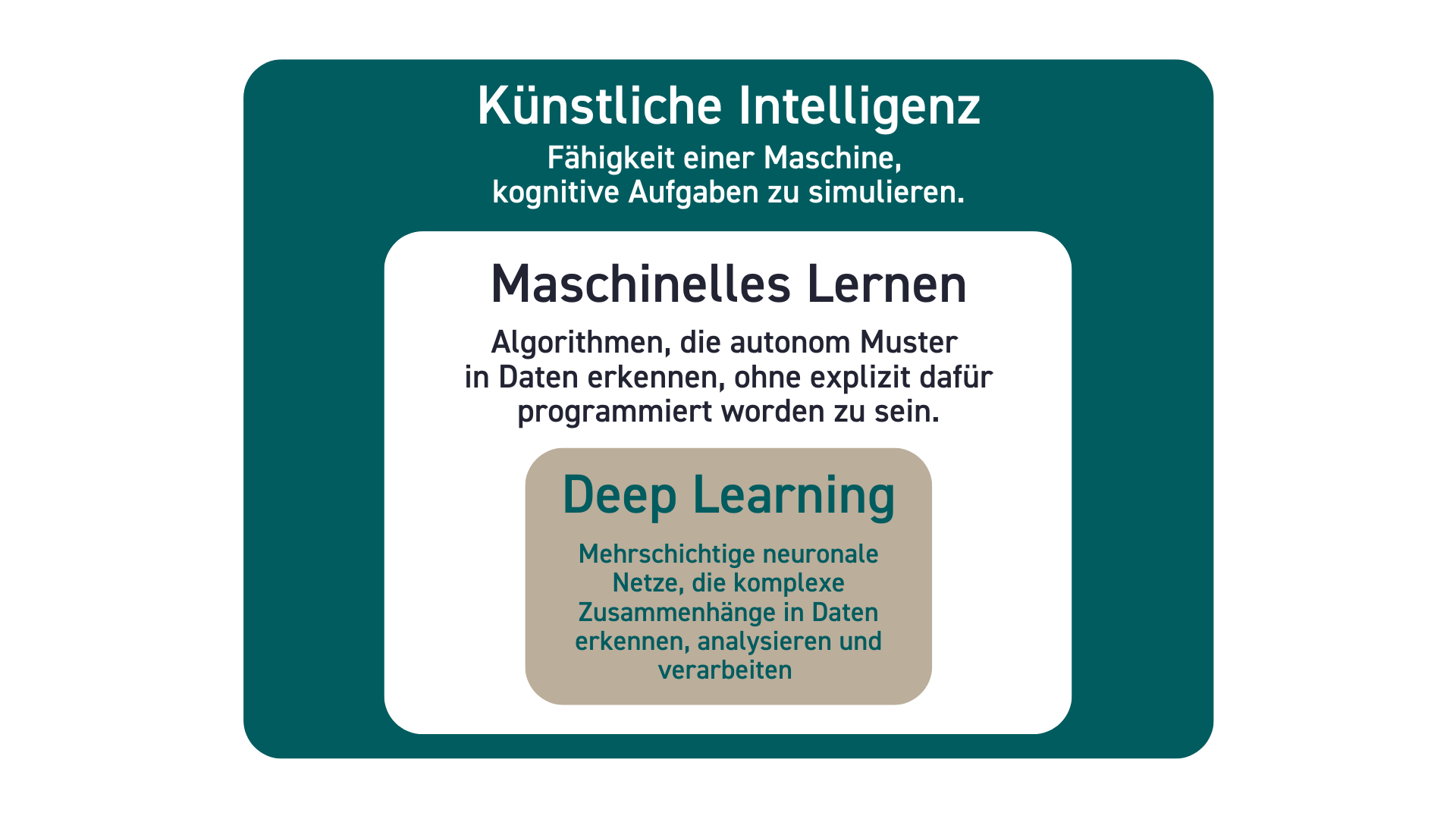

Generative KI nutzt Deep Learning Modelle, also mehrschichtige neuronale Netze, die komplexe Zusammenhänge in Daten erkennen, analysieren und verarbeiten.

Deep Learning Modelle kommen auch in anderen Anwendungen zum Einsatz, beispielsweise bei Sprachassistenten, beim autonomen Fahren oder bei der medizinischen Bildgebung.

Textgenerierende KI-Anwendungen wie ChatGPT bauen auf Large Language Models (LLMs) bzw. Großen Sprachmodellen auf.

- Mit welchen Daten werden Large Language Models vor allem trainiert?

- LLMs werden mit Textdaten trainiert, die primär mittels Webcrawler zusammengetragen werden. Bei den Daten handelt es sich somit vor allem um Webinhalte und Dateien, die über das offene Web abrufbar sind.

- Die Datensätze, die für das Training von LLMs verwendet werden, sind folglich enorm groß.

- Wie funktioniert das Training?

- Zunächst werden die Texte im Trainingsdatensatz in kleinere Einheiten, sogenannte Token unterteilt.

- Im nächsten Schritt werden die Token auf Vektoren abgebildet. D.h. ihnen werden Zahlenwerte zugewiesen, die Zusammenhänge zwischen einzelnen Token abbilden. Diese sogenannten Embeddings ermöglichen es dem Sprachmodell, Muster zu erkennen.

- Das Sprachmodell wird nun darauf trainiert, auf Grundlage dieser Embeddings Text zu generieren. Dabei berechnet das KI-System die Wahrscheinlichkeit des jeweils nächsten Token. Durch Parameter (oder auch Gewichte) kann die Wahrscheinlichkeit beeinflusst werden. Da immer mehrere Token genutzt werden könnten, um einen Satz fortzuführen, muss das System sich für einen Token entscheiden. Diese Entscheidung erfolgt durch eine Dekodierungsstrategie.

- Zuletzt wird dem KI-System beigebracht, Anweisungen genauer zu befolgen. Das bedeutet, dass Menschen mit dem Modell interagieren und dem KI-System durch Beispiele und Bewertungen aufzeigen, welcher Output am besten zu einer Anweisung (Prompt) passt. Durch diesen Schritt lernt das System menschlichen Präferenzen zu entsprechen und keine schädlichen Inhalte zu generieren.

- Wie wird der Output generiert?

- Ausschlaggebend für den Output ist der Prompt. Je mehr Informationen einem KI-Chatbot über den Prompt zur Verfügung gestellt werden, desto mehr Kontext stehen für die Generierung des Outputs zur Verfügung. Das KI-System kann also mit mehr Embeddings rechnen. Wird in einem Chatverlauf mehr als nur ein Prompt eingegeben, werden auch die vorherigen Eingaben und Ausgaben berücksichtigt. Wie viele Ein- und Ausgaben über den sogenannten Kontextspeicher von einem KI-Chatbot abgerufen werden können, hängt vom jeweiligen Modell ab.

LLMs werden also mit sehr großen Mengen von Daten darauf trainiert, natürliche Sprache durch komplexe Berechnungen zu verarbeiten und zu erzeugen. Die grundlegenden Bausteine für die Analyse und Generierung von Texten durch KI-Systeme sind nicht Informationen, sondern Token.

Was bedeutet das für die Nutzung von textgenerierenden KI-Anwendungen?

Die generative KI erzeugt sprachlich korrekte Texte, ohne jedoch zu prüfen, ob der erzeugte Inhalt falsch oder richtig ist. Das kann zu sogenannten Halluzinationen führen, d.h. plausibel wirkende, aber faktisch inkorrekte Antworten. Bei der Verwendung von textgenerierenden KI-Anwendungen ist somit generell nicht gewährleistet, dass die generierten Inhalte richtig sind (mehr unter → Typische Probleme von generativer KI). Es liegt somit immer in der Verantwortung des Users, generierte Inhalte auch bei scheinbarer Plausibilität zu überprüfen.